- Tegoroczni nobliści Baker, Hassabis oraz Jumper zastosowali podejście, które jest de facto rozwinięciem trzech znanych wcześniej metod: modelowania homologicznego, nawlekania sekwencji (threading) a także dynamicznego składania fragmentów (dynamics fragment assembly). W tej sytuacji, mając do dyspozycji całkiem już sporą bazę danych sekwencji, zastosowali metody uczenia maszynowego do aproksymacji nieznanej struktury na podstawie już znanych - Nagrodę Nobla z Chemii komentuje Prodziekan ds. Rozwoju i Informatyzacji Wydziału Chemii dr hab. Artur Giełdoń, prof. UG.

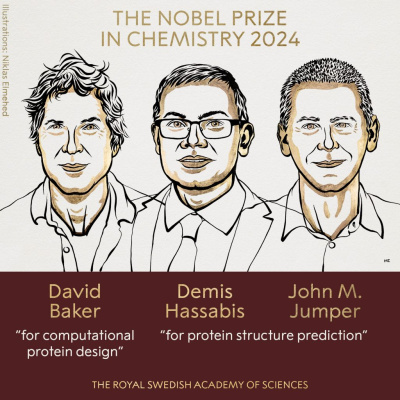

Jak można przeczytać na stronie Komitetu Noblowskiego, w roku 2024 nagrodę otrzymali David Baker „for computational protein design” oraz Demis Hassabis i John Jumper „for protein structure prediction”. Innymi słowy, David Baker otrzymał nagrodę za komputerowe projektowanie białek, natomiast Demis Hassabis i John Jumper za przewidywanie ich struktury.

Gdy mówimy o białkach, większość z nas myśli o ich właściwościach odżywczych. „Jedz jogurt - to białko; jedz gotowane mięso - to białko; nie jedz tego, to sam cukier czy tłuszcz”. Nasze organizmy są zbudowane w ten sposób, że równowaga w spożywaniu wszystkich wymienionych elementów (i wielu niewymienionych) musi być zachowana, by mogły prawidłowo funkcjonować. W tym miejscu wiedza większości z nas się kończy. Jednakże, pod całym płaszczem dietetyki, wszystkie organizmy żywe to skomplikowane maszyny biochemiczne, których funkcjonowanie ciągle staramy się zrozumieć.

Skupmy się na białkach - przedmiocie tegorocznej Nagrody Nobla. W najprostszy sposób możemy je sobie wyobrazić jako małe (rozmiar 2-100 nm (1nm=10-9m)), bardzo wyspecjalizowane nanoroboty. Jedne będą budować nasze mięśnie i odpowiadać za ich ruch, inne naprawiać uszkodzone tkanki, jeszcze inne odpowiadać za trawienie pokarmów, a nawet za proces widzenia i postrzegania otoczenia. Tak więc bez białek nie może istnieć żaden żywy organizm. Nawet wirusy, które trudno nazwać „żywymi”, też są zbudowane z białek. Dlatego ich poznanie jest tak ważne.

Na nasze potrzeby wyobraźmy sobie białko jako koparkę, która ma wykopać fundament pod budowę domu. Operator wchodzi do maszyny, wkłada klucz do stacyjki i wykonuje swoją pracę. I tak dzieje się w normalnym przypadku. Wyobraźmy sobie teraz dwa ekstremalne przypadki. Pierwszy to taki, że ktoś zabrał kluczyk, drugi, że na budowę dostarczono zamiast jednej - 20 koparek. Co musimy zrobić? W pierwszym przypadku dostarczyć kluczyk - by maszynę można było aktywować, w drugim do stacyjki włożyć patyk - bo nadmiar koparek wykopie za duży dół. W taki sposób działa większość leków: przesuwa równowagę pomiędzy nieaktywną a aktywną formą białek. W tym miejscu rodzi się pytanie, jak zaprojektować odpowiedni klucz (lek).

Od początków biochemii robiło się to w taki sposób, że było wiadomo, że dana roślina łagodzi skutki jakiejś choroby. Izolowano jej składniki i sprawdzano empirycznie na masie ochotników (ochotniczych myszy, gotowych oddać życie w służbie biochemii). Dzisiaj wiemy znacznie więcej. Wiemy już, które białka są odpowiedzialne za zachodzące w naszych organizmach procesy. Niestety, jak to w życiu bywa, w tym miejscu trafiamy na przeszkodę natury technicznej. O ile sekwencjonowanie genów odpowiedzialnych za kodowanie białek jest w tej chwili procesem wręcz rutynowym, o tyle proces uzyskiwania struktury przestrzennej białek jest bardzo skomplikowany. Wystarczy, że porównamy ze sobą liczbę wpisów do baz danych - UniProt (sekwencja) 254 miliony; PDB (struktura przestrzenna) 230 tysięcy - by wyobrazić sobie, jak mało jeszcze wiemy i ile odkryć nas czeka. W tym miejscu trzeba dodać, że białko posiadające 200 reszt aminokwasowych może mieć 20^200 możliwych kombinacji sekwencji. I tu zaczyna się rola tegorocznych Noblistów. Na marginesie trzeba dodać, że jest to kontynuacja nagrody przyznanej w 2013 roku Martinowi Karplusowi, Michaelowi Levitowi oraz Ariehowi Warshelowi, która też dotyczyła procesu uzyskiwania struktury przestrzennej białek. W moim prywatnym odczuciu wielkim nieobecnym Nagrody Nobla 2013 był nieżyjący już Harold Scheraga.

Wracając do tematu, na poważnie problem ogromnej rozbieżności pomiędzy liczbą struktur przestrzennych a liczbą sekwencji zostatał zauważony w 1994 roku, kiedy został ogłoszony pierwszy eksperyment (organizatorzy nie lubią słowa konkurs, ale co to za eksperyment, w którym jest ranking przewidywań) dotyczący teoretycznego przewidywania struktur przestrzennych białek tylko na podstawie sekwencji (strona predictioncenter.org). Jedną z osób, która aktywnie go organizuje, jest Polak - Krzysztof Fidelis. Eksperyment polega na tym, że grupy eksperymentalne wysyłają w tajemnicy uzyskane struktury przestrzenne białek. Na stronie CASP można natomiast pobrać sekwencję białka, a następnie wysłać odpowiedź w postaci trójwymiarowego modelu. Organizatorzy porównują ten model z posiadaną strukturą i na tej podstawie ustalają ranking przewidywań. Grupa Gdańska, której jestem członkiem, wielokrotnie uczestniczyła w tym eksperymencie, osiągając niemałe sukcesy. Tak więc śmiem twierdzić, że to właśnie ta inicjatywa pobudziła środowisko naukowe i była motorem postępu w dziedzinie teoretycznego przewidywania struktur przestrzennych białek.

Praca Bakera, Hassabisa oraz Jumpera polega na zaprzęgnięciu metod uczenia maszynowego do uzyskania struktur przestrzennych białek. W tym miejscu trzeba wyróżnić dwa nurty badawcze. Baker uzyskał nagrodę za metody umożliwiające projektowanie białek (Nature, 2016, vol. 537, 320-327) (Baker także bardzo dobrze sobie radził ze swoim programem Rosetta). Hassabis oraz Jumper za metodę uzyskiwania struktur przestrzennych białek (Nature, 2021, vol. 596, 583-589). W tej chwili sytuacja wygląda tak, że nawet mając domowy komputer (desktop, przy którym pracuję, ma 10 rdzeniowy procesor, RTX 4090 oraz 96 GB pamięci), każdy może we własnym zakresie przewidzieć strukturę przestrzenną badanego białka. Taki komputer robi to w 3-6 godzin, w zależności od długości sekwencji. I jest to postęp na miarę Nagrody Nobla.

il. Niclas Emelhed

Trochę nudniejsza część naukowa

Na podstawowym kursie biochemii uczy się studentów o termodynamicznej hipotezie Anfinsena, mówiącej o tym, że struktura białka o najniższej energii przyjmuje konformację natywną. W programach obliczeniowych, a ze względu na ogromną liczbę atomów mówimy tu głównie o empirycznych polach siłowych, mamy ściśle zdefiniowaną funkcję energii. Zależy ona między innymi od wartości długości wiązań, kątów walencyjnych oraz torsyjnych, a także oddziaływań elektrostatycznych i van der Waalsa. Zatem skoro jesteśmy w stanie dobrze wyznaczyć energię białka, to w czym problem? Otóż problemy są dwa. Na nasze potrzeby możemy sobie wyobrazić wykres takiej funkcji, który będziemy nazywali wykresem hiperpowierzchni energii potencjalnej, jako pole golfowe z górami, dolinami oraz dołkami. I takie wyobrażenie są w stanie „udźwignąć” nasze ludzkie umysły - przestrzeń trójwymiarową. Wielki polski matematyk Stefan Banach widział 5 wymiarów i na tym koniec. Tu problem wygląda tak, że nasza funkcja będzie miała 3n - 6 (gdzie n będzie się równała liczbie atomów) stopni swobody. To oznacza, że tyle wymiarów będzie miała w rzeczywistości funkcja energii, której minimum chcemy znaleźć. By nie było tak prosto, prawie nigdy minimum energii potencjalnej nie odpowiada strukturze natywnej białka. Prof. Harold Scheraga na swoich wykładach rysował wykres z dwoma bardzo dobrze zdefiniowanymi minimami. Pierwsze było szerokie i niezbyt głębokie, drugie ostre i bardzo głębokie. No więc, gdzie znajdziemy poszukiwaną strukturę natywną? W miejscu bardziej prawdopodobnym - czyli w szerokim i niezbyt głębokim. Czyli w miejscu o najniższej energii swobodnej, a nie potencjalnej. Wyobraźmy sobie na naszym polu golfowym biegającego psa oraz fakt, że przy ostatnim dołku zakopano kość. Pies będzie biegał wokół dołka, węsząc zaciekle (możemy to nazwać potencjałem chemicznym), samemu będąc w minimum (przyjmując strukturę natywną). Jednakże jak to w życiu bywa, nasze pole golfowe powstało w miejscu, gdzie było kiedyś gospodarstwo z własną studnią. Studnia była zabezpieczona, ale przez lata deski zbutwiały, a w konsekwencji nasz pies tam wpadł. Pies utknie w studni, dopóki ktoś go nie uratuje. Tak w uproszczeniu przedstawia się różnica między energią potencjalną a swobodną. Tak samo jest z białkami. Organizm broni się przed niewłaściwie zwiniętymi białkami, naprawiając je przy użyciu białek opiekuńczych lub niszcząc, gdyż zwinięte niewłaściwie mogą wyrządzić więcej szkód niż pożytku. Opisany powyżej sposób uzyskania struktur przestrzennych białek jest zastosowany w całej masie różnego rodzaju pól siłowych. Jedno z nich jest nawet rozwijane w Grupie Gdańskiej, pod kierunkiem prof. Adama Liwo. Jest to pole siłowe UNRES.

Tegoroczni nobliści Baker, Hassabis oraz Jumper zastosowali inne podejście, które jest de facto rozwinięciem trzech znanych wcześniej metod: modelowania homologicznego, nawlekania sekwencji (threading) a także dynamicznego składania fragmentów (dynamics fragment assembly). W tej sytuacji, mając do dyspozycji całkiem już sporą bazę danych sekwencji, zastosowali metody uczenia maszynowego do aproksymacji nieznanej struktury na podstawie już znanych. Posiadana baza danych struktur przestrzennych białek jest już na tyle duża, że proces zakończył się powodzeniem. W przeciwieństwie do opisanej wcześniej metody, w tym przypadku nie potrzeba ogromnej mocy obliczeniowej i superkomputera. Potrzebny jest natomiast dysk SSD o pojemności przynajmniej 4TB i dobra karta graficzna.

Z drugiej strony, przeglądając bazę danych UniProt (w której jest zdeponowanych bardzo wiele modeli uzyskanych komputerowo), możemy zobaczyć, że część z nich ma nieustrukturyzowane fragmenty (jest to widoczne w ostatniej kolumnie pliku pdb, w której jest podane prawdopodobieństwo odgadnięcia danego fragmentu strukturalnego). Tak więc jest jeszcze nad czym pracować.

Tak jak w roku 2013 wielkim nieobecnym był Harold Scheraga, w roku 2024 wielkim nieobecnym jest Yang Zhang, którego grupa opracowała program I-Tasser. Ścieżki Komitetu Noblowskiego są nieznane…